数据处理是现代信息技术的核心环节,它涉及对原始数据进行采集、清洗、转换、分析和存储等一系列操作,最终目的是提取有价值的信息,支持决策与创新。

数据处理的基本流程

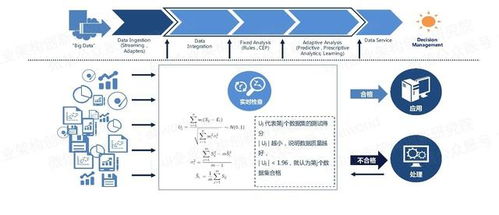

数据处理通常遵循一个标准化的流程,以确保结果的准确性和一致性。这个流程一般包括以下几个关键步骤:

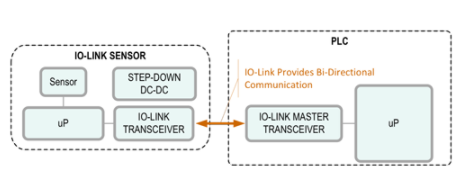

- 数据收集:从各种来源(如数据库、传感器、日志文件、互联网等)获取原始数据。这是整个流程的起点。

- 数据清洗:识别并纠正数据中的错误、不一致、重复和缺失值。例如,处理“poYBAGKN956AVzKhAAB8U60YN5s513.png”这类非结构化或命名不规范的文件,可能需要将其重命名、分类或提取元数据。这一步至关重要,因为“垃圾数据进,垃圾数据出”。

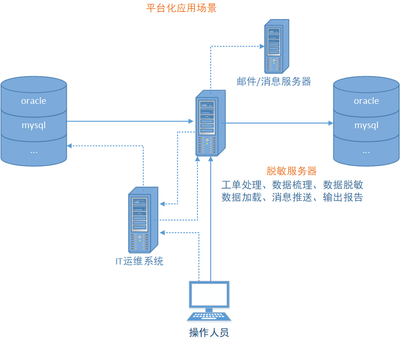

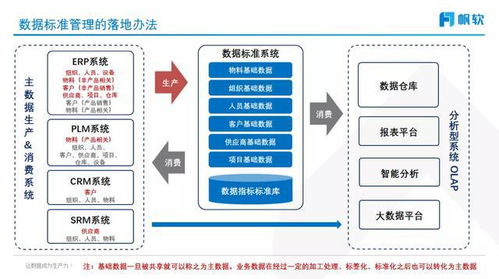

- 数据转换与集成:将清洗后的数据转换为统一的格式或结构,并可能将来自不同来源的数据合并在一起,形成适合分析的数据集。

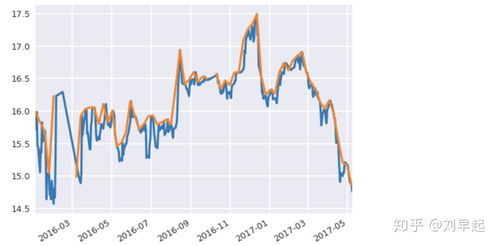

- 数据分析:运用统计分析、机器学习、数据挖掘等方法,探索数据模式、趋势和关联,以产生洞察。

- 数据存储与可视化:将处理后的结果存储于数据库或数据仓库中,并通过图表、仪表盘等形式直观呈现,便于理解和传播。

核心技术工具与方法

- 编程语言与库:Python(Pandas, NumPy)、R语言是数据处理的利器,它们提供了强大的数据操作和分析功能。

- 数据库技术:关系型数据库(如MySQL, PostgreSQL)和非关系型数据库(如MongoDB)用于高效存储和查询数据。

- 大数据框架:面对海量数据,Hadoop、Spark等分布式计算框架能够进行并行处理,极大提升效率。

- ETL/ELT工具:专门用于数据提取、转换和加载的软件,如Apache Airflow、Talend等,有助于自动化数据处理流水线。

- 机器学习与AI:为数据处理注入智能,实现预测、分类和自动化决策。

应用场景与挑战

数据处理广泛应用于各行各业:

- 商业智能:分析销售数据以优化库存和营销策略。

- 科学研究:处理实验数据或天文观测数据以验证假设。

- 智能制造:通过传感器数据监控设备状态,实现预测性维护。

- 金融风控:实时处理交易数据以检测欺诈行为。

数据处理也面临诸多挑战,包括数据量的爆炸式增长(大数据)、数据质量的参差不齐、数据安全与隐私保护、以及处理速度的实时性要求等。

###

无论是处理一张名为“poYBAGKN956AVzKhAAB8U60YN5s513.png”的图像文件,还是分析TB级的用户日志,数据处理都是一项系统性工程。它要求从业者不仅掌握技术工具,更需具备对业务的理解和对数据质量的严谨态度。随着技术的不断发展,数据处理正变得更加自动化、智能化,成为驱动数字化转型和创新的关键动力。