R语言作为一门专门为统计分析、数据可视化和数据处理而设计的编程语言,凭借其强大的数据操作能力和丰富的扩展包,已成为数据科学家和研究人员不可或缺的工具。高效的数据处理是数据分析流程中至关重要的第一步,它直接影响到后续建模、可视化和决策的准确性与可靠性。

一、数据处理的基础:数据结构与读取

R语言提供了多种核心数据结构来存储和处理数据,其中最常用的是数据框(data.frame),它类似于电子表格,行代表观测,列代表变量。向量(vector)、矩阵(matrix)、列表(list)和因子(factor)也是基础且重要的结构。数据处理的起点通常是数据导入。R可以轻松读取多种格式的数据文件,例如:

- 使用

read.csv()或read.table()读取CSV、TXT等文本文件。 - 使用

readxl包中的read_excel()读取Excel文件。 - 使用

haven包读取SPSS、SAS、Stata等统计软件的数据文件。 - 直接从数据库(如MySQL、PostgreSQL)或网络API获取数据。

二、数据清洗与整理的核心技术

- 数据筛选与排序:使用基础R的

subset()函数或更流行的dplyr包中的filter()和arrange()函数,可以方便地根据条件筛选行和按列排序。 - 变量选择与重命名:

dplyr包的select()函数可以快速选择、排除或重排列;rename()函数则可直观地修改变量名。 - 处理缺失值:缺失值(NA)的处理是清洗的关键。可以使用

is.na()检测缺失值,并用na.omit()删除含有缺失值的行,或使用tidyr包的drop<em>na()、replace</em>na()进行更精细的控制。对于数值变量,常用均值、中位数或模型预测值进行填补。 - 数据类型转换:确保每列的数据类型正确是后续分析的基础。使用

as.numeric()、as.factor()、as.Date()等函数进行转换,dplyr的mutate()结合across()能实现批量转换。 - 重复值处理:使用

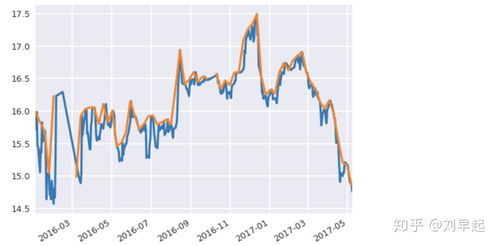

duplicated()识别重复行,或用dplyr的distinct()直接删除重复项。 - 异常值检测与处理:可以通过箱线图、散点图可视化发现异常值,或使用统计方法(如Z-score、IQR)识别。处理方式包括删除、转换或用缩尾法(Winsorization)调整。

三、高效数据操作:tidyverse生态

tidyverse 是一个强大的R包集合,它提供了一套连贯、高效且易读的数据处理语法,极大地提升了工作效率。其核心包括:

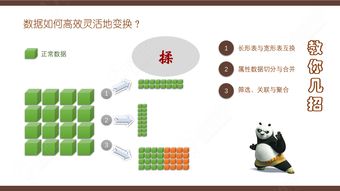

dplyr:提供数据操作的“动词”,如filter(),select(),mutate()(创建新变量),summarise()(汇总统计), 以及强大的group_by()与以上动词结合进行分组操作。tidyr:专注于数据整理,实现“整洁数据”(每列是一个变量,每行是一个观测)。关键函数有pivot<em>longer()(宽数据变长)、pivot</em>wider()(长数据变宽)、separate()(拆分列)和unite()(合并列)。stringr:提供完整的字符串处理函数集,用于文本清洗和模式匹配。lubridate:简化日期-时间数据的解析和计算。

一个典型的数据处理管道(使用管道运算符 %>% )如下所示:`r

library(tidyverse)

cleandata <- rawdata %>%

filter(!is.na(income)) %>% # 删除收入为NA的行

select(id, age, income, department) %>% # 选择所需列

mutate(incomegroup = cut(income, breaks = c(0, 50000, 100000, Inf),

labels = c('Low', 'Medium', 'High'))) %>% # 创建新分类变量

groupby(department, incomegroup) %>%

summarise(avgage = mean(age), .groups = 'drop') # 按部门与收入组计算平均年龄`

四、数据合并与连接

在实际分析中,数据常分散在多个表格中。R提供了多种合并方式:

- 纵向合并:使用

rbind()或dplyr的bind_rows()将结构相同的数据框上下堆叠。 - 横向合并:这是更常见的需求,即根据一个或多个关键变量连接表格。

dplyr提供了一系列直观的联接函数: inner_join():返回两个表中键匹配的行。

left_join():返回左表所有行,匹配右表列。

right<em>join()与full</em>join():分别对应右连接和全外连接。

五、性能优化与大数据处理

当处理海量数据时,基础R和数据框可能遇到性能瓶颈。此时可考虑:

data.table包:以其极快的速度和内存效率著称,特别适合大型数据集的分组、聚合和连接操作。其语法紧凑,学习曲线较陡但回报丰厚。- 箭头(Arrow)包:支持处理超出内存大小的数据集,允许在本地以列式格式高效处理数据,并与

dplyr语法无缝集成。 - 并行计算:利用

parallel、future等包进行并行处理,加速循环和迭代操作。

六、最佳实践与

- 保持可复现性:将数据处理步骤编写成清晰的脚本,并使用R Markdown或Quarto文档记录整个过程。

- 版本控制:使用Git管理数据处理脚本和关键数据的版本。

- 模块化与函数化:将重复的数据清洗任务封装成自定义函数,提高代码复用性和可维护性。

- 探索性数据清洗:在处理前后,结合

summary()、str()、glimpse()(dplyr)以及可视化(如ggplot2)来理解数据分布和检查清洗效果。

R语言为数据处理提供了一个极其强大且灵活的环境。从基础的子集选取、缺失值处理,到利用 tidyverse 进行声明式、管道化的数据整理,再到使用 data.table 应对性能挑战,R用户拥有完整的工具链。掌握这些工具和思想,能够将原始、混乱的数据转化为整洁、可用于分析的格式,为任何数据科学项目奠定坚实的基础。